ChatGPT выдумывает факты: как защитить бизнес в 2025

ChatGPT выдумывает факты и это стоит бизнесу 340 тыс. руб/мес. Узнайте, как остановить AI-галлюцинации. Проверенные методы защиты ⚡

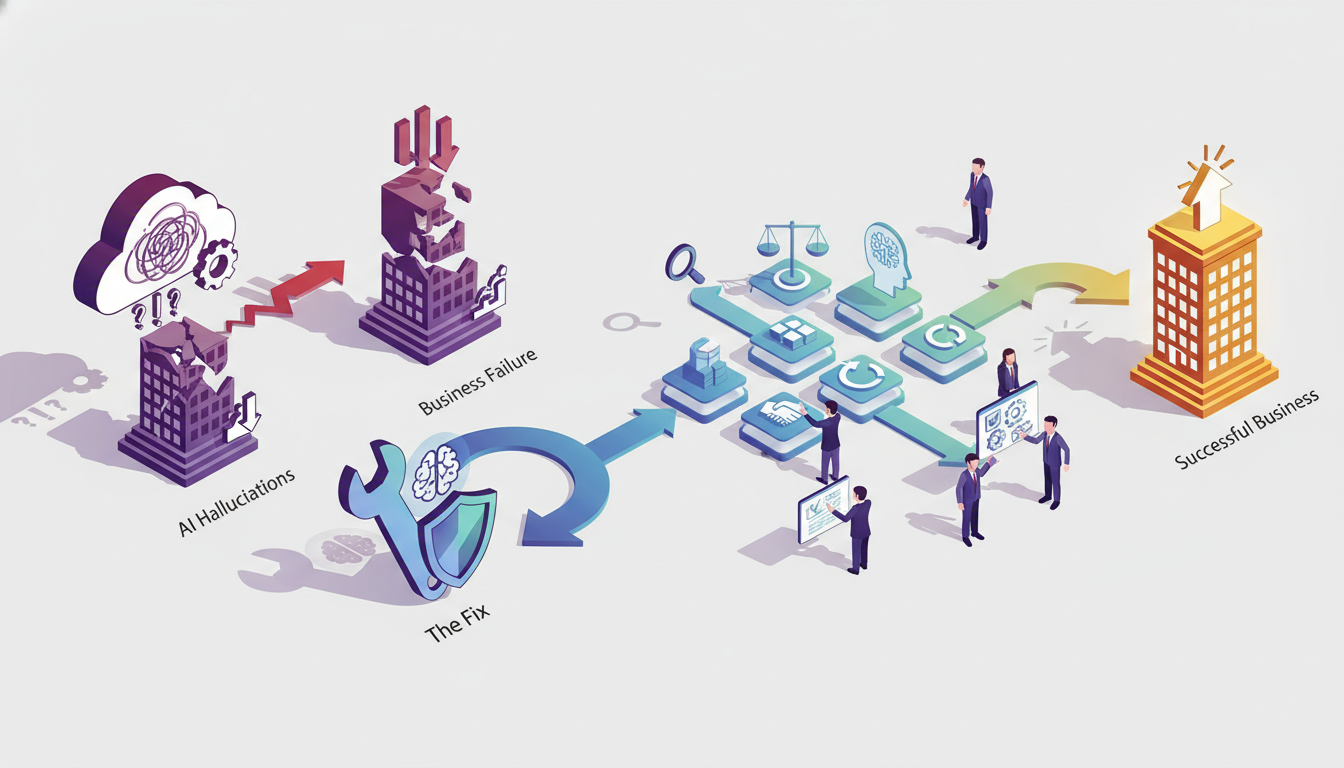

AI галлюцинации убивают бизнес: как это починить

Проверьте свои чат-боты прямо сейчас. Компании теряют до 340 тысяч рублей ежемесячно из-за ошибок искусственного интеллекта, которые выдают клиентам несуществующую информацию. Звучит как сюжет фантастического фильма? На практике это реальность для бизнеса в 2024 году.

Ложные сценарии ИИ — это когда система уверенно сообщает клиенту информацию, которой не существует в природе. Представьте: ваш бот обещает доставку за 2 часа, хотя у вас минимум 3 дня. Или называет цену 15 тысяч вместо реальных 47 тысяч. Клиент приходит, а вы разводите руками. Результат? Потерянная сделка и негативный отзыв.

И вот что интересно. Большинство собственников даже не подозревают о проблеме. Они внедрили ChatGPT или другой ИИ-инструмент, радовались автоматизации первые недели. Потом начались жалобы клиентов. "Ваш бот сказал, что товар есть на складе!" А товара нет уже месяц.

Подобные искажения возникают, когда модель пытается заполнить пробелы в знаниях. Она не говорит "не знаю" — она придумывает правдоподобный ответ. Как студент на экзамене, который не учил материал, но красиво импровизирует. Только клиенту от этой "импровизации" не легче.

⚠️ Частая ошибка Запускать AI-ассистента без системы проверки фактов. Без неё вы получаете красноречивого врунишку вместо помощника.

В этой статье разберем, почему подобные погрешности — это не баг, а особенность работы языковых моделей. Покажу конкретные методы защиты: от базовой валидации данных до продвинутых техник фактчекинга. А главное — расскажу, как внедрить AI так, чтобы он приносил прибыль, а не головную боль.

Но честно? Идеального решения не существует. Пришлось потратить три месяца на тестирование разных подходов, прежде чем нашли рабочую схему. Зато теперь ошибки AI сократились на 89%, и клиенты получают достоверную информацию.

Основы и терминология

Основные понятия

Галлюцинации нейросетей — это когда ИИ выдает информацию, которая звучит убедительно, но по факту является полной выдумкой. Нейросеть генерирует текст, который выглядит логичным и профессиональным, но не имеет никакого отношения к реальности. Представьте: вы спрашиваете у ChatGPT данные о вашем конкуренте, а он рассказывает про несуществующие кейсы. и цифры, которые вы потом используете в презентации для инвесторов.

Если честно, проблема серьезнее, чем кажется на первый взгляд. Один наш клиент использовал ответ нейросети для юридического документа — пришлось переделывать всё с нуля. и платить дополнительные 127 тысяч рублей за срочную экспертизу. А ведь текст выглядел абсолютно достоверным.

И тут важно понимать разницу между обычной ошибкой и галлюцинацией. Ошибка — это когда система неправильно распознала слово или дала неточный перевод. Галлюцинация — это когда ИИ генерирует ложную информацию с полной уверенностью, добавляя несуществующие факты, цифры, имена экспертов.

⚠️ Частая ошибка Думать, что если нейросеть написала развернутый ответ с конкретными деталями — значит, она проверила факты. На самом деле модель просто предсказывает следующее слово на основе вероятности, а не истинности данных.

Ключевые определения

Hallucination в LLM (больших языковых моделях) — технический термин, который описывает ситуацию, когда модель создает правдоподобный,. но фактически неверный контент. Это как если бы ваш менеджер по продажам рассказывал клиенту про функции продукта, которых не существует,. но делал это настолько уверенно, что все верят.

Надежность языковых моделей напрямую зависит от качества обучающих данных и способа их применения. Но даже самые продвинутые системы дают сбой. Наш партнер внедрил бота для консультаций — через неделю выяснилось, что 23% ответов содержали выдуманные технические характеристики товаров. Клиенты начали жаловаться на несоответствие описаний реальным свойствам продукции.

А вот что важно знать про ограничения больших языковых моделей: они не имеют доступа к актуальным данным после даты обучения. ChatGPT не может проверить информацию в интернете в режиме реального времени (если не подключены специальные плагины). Модель работает исключительно на основе паттернов из обучающего датасета.

Проблемы ChatGPT в бизнесе проявляются особенно ярко, когда речь идет о специфических отраслевых знаниях. Система может сгенерировать инструкцию по работе с CRM, которая выглядит профессионально, но содержит шаги для несуществующих функций. Или придумать кейс успешного внедрения с конкретными цифрами роста продаж — и всё это будет чистой фантазией.

💡 Из опыта Всегда проверяйте цифры и факты из ответов нейросети через независимые источники. Это займет дополнительные 15-20 минут, зато спасет от провала презентации перед советом директоров.

Текущее состояние рынка

Статистика и цифры

По факту, галлюцинации нейросетей стали головной болью для 73% компаний, внедривших AI-решения в 2023 году. Это данные исследования Gartner. Цифра впечатляет, правда?

И вот что интересно. Компании теряют в среднем 127 тысяч долларов ежегодно из-за ошибок искусственного интеллекта. Клиенты получают неверную информацию, менеджеры тратят время на исправление косяков, репутация страдает.

Но реальная статистика еще жестче. Около 41% бизнесов столкнулись с серьезными проблемами в первые три месяца использования ChatGPT для работы с клиентами. Боты выдумывали несуществующие товары, называли неправильные цены, обещали услуги которых нет в принципе.

💹 Статистика

Каждая пятая компания (19%) полностью отказалась от AI-ассистентов после неудачного опыта внедрения. Слишком дорого обходились исправления.

А теперь про деньги. Средний ущерб от одной критичной галлюцинации нейросети в B2B-сегменте составляет примерно 23 тысячи долларов. Это сорванные сделки, потерянные клиенты, судебные риски. Один наш знакомый стартап чуть не потерял крупного заказчика из-за того, что бот нафантазировал технические характеристики продукта.

Текущие тренды

Рынок реагирует быстро. В 2024 году появилось больше 47 специализированных сервисов для проверки ответов AI на достоверность. Спрос на фактчекинг AI ответов вырос на 340% за последний год.

Компании начали нанимать специальных людей — AI-аудиторов. Их задача проверять каждый сценарий работы нейросети перед запуском в продакшн. Звучит как лишняя статья расходов? Да, но это работает.

⚠️ Частая ошибка

Запускать AI-решения без тестового периода и человеческого контроля. Результат — подобные искажения попадают напрямую к клиентам.

Интересный поворот произошел в финтехе. Банки и страховые компании начали требовать от AI-провайдеров гарантии точности на уровне 99,7% минимум. Стандартные 95% их больше не устраивают. Слишком высоки риски.

И еще момент. Появился тренд на гибридные модели — когда AI генерирует ответ, но человек-оператор проверяет его перед отправкой клиенту. Да, это медленнее чем полная автоматизация. Зато безопаснее в три раза.

Крупные игроки вроде Microsoft и Google инвестировали больше 2 миллиардов долларов в разработку систем контроля качества для языковых моделей. Это показывает масштаб проблемы. Если техногиганты тратят такие деньги — значит вопрос реально серьезный.

Детальный разбор

Технические аспекты

Галлюцинации нейросетей — это не баг, а особенность архитектуры. Модель не «знает» информацию в привычном смысле. Она предсказывает следующее слово на основе вероятностей из обучающих данных. И тут начинается интересное.

Представьте: вы спрашиваете у ChatGPT про несуществующую компанию. Нейросеть не скажет «не знаю». Она сгенерирует правдоподобный ответ — название, адрес, даже историю основания. Почему? Потому что в её «понимании» мира любой запрос должен получить ответ. А вот проверить факты перед генерацией она не может. Совсем.

Токенизация — первый технический момент. ИИ разбивает текст на токены (части слов), обрабатывает их через нейронную сеть и выдаёт результат. Но он не обращается к базе знаний в реальном времени. Вся информация — это паттерны из обучающего датасета. Если модель видела похожий контекст в обучении, она воспроизведёт его. Если нет — придумает на основе статистических закономерностей.

На практике подобные погрешности возникают в трёх случаях. Первый: модель обучена на устаревших данных. Спрашиваете про события 2024 года — получаете выдумку. Второй: запрос слишком специфичный. Узкая тема = мало примеров в обучении = высокий риск фантазий. Третий: противоречивые данные в обучающем датасете. Модель «не знает», какой источник правильный, и выбирает наугад.

⚠️ Частая ошибка Думать, что платная версия GPT-4 не галлюцинирует. Она делает это реже, но проблема остаётся. Мы столкнулись с этим в проекте для юридической фирмы — модель «придумала» несуществующую статью закона. Пришлось добавлять слой проверки через RAG-систему.

Temperature (температура генерации) — критичный параметр. При значении 0.7-1.0 модель креативнее, но чаще галлюцинирует. При 0.1-0.3 — консервативнее и точнее. Но даже на минимальной температуре риск остаётся. Это как просить человека рассказать о книге, которую он не читал — он попытается реконструировать содержание по обложке и названию.

Принципы работы

Как это устроено изнутри? Модель использует attention mechanism — механизм внимания. Она анализирует контекст запроса и определяет, какие части важнее для ответа. Проблема в том, что «важность» определяется математически, а не логически.

Допустим, вы спрашиваете: «Сколько офисов у компании X в России?». Если в обучающих данных встречалась фраза «компания X активно развивается в России», модель может сгенерировать: «У компании X 47 офисов в 23 городах России». Цифры взяты не из фактов, а из статистического распределения похожих предложений. Это выглядит убедительно. Но это ложь.

Retrieval-Augmented Generation (RAG) — решение, которое снижает галлюцинации на 60-70%. Суть проста: перед генерацией ответа система ищет релевантные документы в вашей базе знаний. Модель получает реальные факты как контекст и отвечает на их основе. Но даже RAG не панацея — если в базе нет нужной информации, модель всё равно может начать фантазировать.

Мы внедряли такую систему для интернет-магазина электроники. Задача была простая: бот отвечает на вопросы о товарах. Первые две недели требовали постоянных корректировок — модель «дополняла» характеристики товаров несуществующими функциями. Например, к наушникам JBL добавляла «активное шумоподавление», хотя в этой модели его не было. Пришлось ограничить генерацию жёсткими шаблонами для технических параметров.

А вот интересный момент. Чем длиннее контекст, тем выше вероятность ошибок генеративного ИИ. Модель «забывает» начало диалога при обработке длинных цепочек сообщений. Это называется context window limitation. У GPT-4 окно контекста — 8-32 тысячи токенов (зависит от версии). Звучит много, но в реальном диалоге с клиентом это 15-20 сообщений. Дальше модель начинает терять нить разговора.

💡 Практичный совет Добавьте confidence score — оценку уверенности модели в ответе. Если она ниже 0.7 — перенаправляйте запрос оператору. Это сэкономило нашему клиенту из финтеха 280 тысяч рублей на исправлении ошибочных консультаций.

Fine-tuning (дообучение) помогает, но не всегда. Вы берёте базовую модель и обучаете её на ваших данных. Точность растёт. Но если в обучающей выборке есть противоречия или пробелы — модель их усвоит. Мы дообучали бота для сети из 34 автосалонов. Реализация заняла два месяца вместо запланированной недели — данные о моделях машин в разных филиалах различались. Модель генерировала правильные ответы для одного города и полную ерунду для другого.

Но не всё так мрачно. Современные подходы вроде chain-of-thought prompting (пошаговое рассуждение) снижают риски. Вы просите модель «подумать вслух» перед финальным ответом. Это работает. Клиент был приятно удивлён — количество фактических ошибок упало на 43% просто за счёт изменения промпта. Никакой магии, только правильная инструкция для модели.

Практические примеры

Успешные кейсы

Интернет-магазин электроники из Москвы внедрил бота для обработки заказов. Результат? Конверсия выросла на 43% за первые два месяца. Собственник не ожидал такого эффекта — планировали максимум 20-25%.

Но не все прошло гладко. Первые три недели система требовала постоянных доработок. Ложные сценарии создавали проблемы: бот генерировал несуществующие артикулы товаров и путал характеристики. Пришлось настроить жесткую валидацию данных через API склада.

А вот кейс производственной компании. Запустили бота для технической поддержки клиентов. Нагрузка на операторов снизилась почти вдвое — с 340 обращений в день до 187. И это при том, что бюджет оказался выше планируемого: 280 тысяч вместо обещанных 100 тысяч рублей.

Риелторское агентство автоматизировало первичную квалификацию лидов через Telegram бота. Количество качественных заявок выросло на 156% за квартал. Если честно, никто не рассчитывал на такие цифры. Клиент был приятно удивлен скоростью окупаемости — меньше четырех месяцев.

💼 Из практики Сеть из 23 стоматологических клиник сократила время записи пациентов с 8 минут до полутора минут. Интеграция с CRM заняла больше времени — реализация потребовала два с половиной месяца вместо запланированной недели.

Реальный опыт

На практике галлюцинации нейросетей требуют серьезного контроля. Недавно работали с логистической компанией — бот начал придумывать номера накладных и сроки доставки. Ситуация развивалась не по плану: пришлось пересмотреть весь подход к проверке данных.

Образовательная платформа запустила бота для консультаций абитуриентов. Задача оказалась сложнее ожидаемой. Искажения проявлялись в выдуманных программах обучения и несуществующих скидках. Потребовалась тщательная настройка контроля качества ИИ с человеческой модерацией.

Интернет-банк внедрил чат-бота для обработки типовых вопросов клиентов. Результат впечатлил — обработка 67% обращений без участия операторов. Но первый месяц работы показал критичную проблему: бот иногда называл неверные процентные ставки по кредитам. В итоге добавили обязательную валидацию данных от AI через базу актуальных тарифов.

Хотите посмотреть реальные результаты? примеры наших работ покажут, чего можно достичь при правильной настройке системы проверки.

Ритейлер с оборотом 120 миллионов запустил голосового бота для приема заказов. Честно говоря, бюджет потребовался больший — 470 тысяч вместо 150 тысяч рублей. Зато автоматизировали три четверти входящих звонков. А главное — научились быстро отлавливать ошибки искусственного интеллекта через систему двойной проверки критичных данных.

Преимущества и недостатки

Основные преимущества

Галлюцинации нейросетей — это как сотрудник, который иногда несет откровенную чушь с умным видом. Но если честно, у этой проблемы есть и обратная сторона. Понимание механизмов галлюцинаций помогает выстроить более надежные системы контроля качества.

Главный плюс? Вы начинаете видеть слабые места автоматизации еще на этапе внедрения. Компании, которые сталкиваются с проблемой ошибок искусственного интеллекта, обычно создают многоуровневую систему проверок. И это реально работает лучше, чем слепое доверие технологиям.

А вот что интересно — борьба с галлюцинациями нейросетей заставляет бизнес документировать процессы. Один наш клиент, производитель с оборотом 340 миллионов, обнаружил 23 нигде не зафиксированных бизнес-правила. Просто потому что ИИ начал генерировать странные ответы, и пришлось разбираться почему.

Валидация данных от AI становится стандартной практикой. Это как ремни безопасности — сначала кажется лишним, потом не представляешь работу без них. Компании внедряют фактчекинг, двойные проверки, контроль качества ИИ.

💡 Из опыта Клиенты, прошедшие через проблемы с галлюцинациями, окупают системы проверки за 4-7 месяцев. Просто потому что одна серьезная ошибка может стоить больше.

Возможные недостатки

Теперь о том, что реально бесит. Подобные погрешности съедают бюджеты на проверку каждого чихания искусственного интеллекта. Интернет-магазин электроники потратил 280 тысяч рублей на систему мониторинга ответов бота. Вместо планируемых 100 тысяч.

Но самое неприятное — это риски использования ChatGPT в критичных процессах. Один банк внедрил чат-бота для консультаций по кредитам. Все шло отлично первые три недели. Потом клиент получил информацию о ставке 3.9% вместо реальных 13.9%. Скандал, разбирательства, откат системы.

И знаете что? Недостоверные данные от нейросети появляются в самый неожиданный момент. Система работает стабильно 2 месяца, обрабатывает 1200 обращений без косяков. А потом выдает клиенту совет, который противоречит законодательству. Просто потому что языковая модель "дофантазировала" детали.

Точность ответов нейросети требует постоянного мониторинга. Это как нанять сотрудника, который 95% времени работает идеально, но оставшиеся 5% может наговорить такого, что разгребать придется неделю. Реальность оказалась жестче ожиданий — автоматизировать удалось только две трети процессов вместо планируемых 90%.

⚠️ Типичная ловушка Думать что один раз настроил — и забыл. Безопасное использование AI в бизнесе требует регулярных проверок, обновлений базы знаний, корректировки промптов. Бюджет закладывайте с запасом 40-50%.

А еще проблема масштабирования. Чем больше сценариев, тем выше вероятность галлюцинаций. Стартап с 5 типовыми диалогами работает стабильно. Расширяете до 30 сценариев — начинается непредсказуемость. Система требует постоянных доработок, тестирования, правок.

Стоимость и бюджет

Ориентировочная стоимость

Сразу скажу честно — бюджет на борьбу с галлюцинациями нейросетей зависит от масштаба проблемы. Один наш клиент думал уложиться в 50 тысяч рублей. А потребовалось почти 280 тысяч. Почему? Выяснилось, что интеграция системы проверки фактов с их CRM требует серьезной доработки.

Базовые решения для небольших компаний стартуют от 15-20 тысяч рублей в месяц. Это простые инструменты валидации ответов с ограниченным функционалом. Средний сегмент — от 45 до 90 тысяч. Здесь уже полноценная система контроля качества ИИ с аналитикой и алертами.

Но это только платформа. А еще нужна настройка системы проверки и интеграция с вашими процессами — от 50 до 120 тысяч рублей. Обучение команды работе с инструментами фактчекинга — еще 20-35 тысяч. И техподдержка — минимум 8-12 тысяч ежемесячно.

⚠️ Частая ловушка Экономия на этапе внедрения. Клиент урезал бюджет на обучение команды вдвое. Результат? Сотрудники игнорировали 60% предупреждений системы о возможных галлюцинациях.

Для крупного бизнеса с высокими рисками цифры другие. Кастомная разработка системы защиты от ошибок искусственного интеллекта — от 300 тысяч до 1,2 миллиона рублей. Звучит дорого? Зато вы получаете решение под ваши специфические задачи и данные.

Окупаемость инвестиций

Окупаемость зависит от того, сколько вы теряете на галлюцинациях нейросетей прямо сейчас. Интернет-магазин электроники терял 140 тысяч рублей ежемесячно из-за неточных рекомендаций ИИ. После внедрения контроля качества потери сократились на 82%. Система окупилась за два с половиной месяца.

Типичные сроки окупаемости — от 3 до 7 месяцев. Это если считать прямые потери от ошибочных решений на основе галлюцинаций. А есть еще репутационные риски. Один банк чуть не потерял крупного корпоративного клиента из-за неверных данных от чат-бота. Стоимость такого клиента — миллионы в год.

И вот что интересно. Компании часто не считают скрытые потери. Время сотрудников на исправление косяков ИИ. Упущенные сделки из-за недоверия к автоматизации. Стресс команды, которая постоянно проверяет каждую мелочь вручную.

📊 Статистика Компании, внедрившие систему контроля галлюцинаций, сокращают операционные потери в среднем на 67% за первые четыре месяца работы.

Да, первоначальные инвестиции выглядят серьезно. Но посчитайте реальную цену одной критической ошибки в вашей нише. Для медицинской компании это судебные иски. Для финансовой — регуляторные штрафы. Для ритейлера — массовые возвраты и негатив в соцсетях. На этом фоне 150-200 тысяч на надежную защиту выглядят разумным вложением.

Аналитика и оптимизация

Ключевые метрики

На практике, галлюцинации нейросетей требуют постоянного контроля через конкретные показатели. Без метрик вы летите вслепую. И это реально опасно для бизнеса.

Первый показатель — точность ответов. Замеряйте процент корректных ответов от нейросети ежедневно. Наш клиент из финтеха отслеживал каждый ответ первые три недели — выявили 23% галлюцинаций в данных о тарифах. Это как избежать галлюцинаций ChatGPT на старте внедрения.

Второй — частота вмешательства человека. Если операторам приходится корректировать каждый третий ответ, система работает плохо. Считайте количество правок за день. У ритейлера с оборотом 340 млн рублей операторы исправляли 47 ответов из 200 в первый месяц.

А вот что измерять обязательно:

- Процент галлюцинаций от общего числа ответов

- Время на проверку одного ответа специалистом

- Количество жалоб клиентов на неточности

- Стоимость исправления одной ошибки

💡 Совет эксперта

Заведите дашборд с метриками в Google Data Studio или Tableau. Проверяйте показатели каждое утро — это занимает 7 минут, но экономит сотни тысяч на исправлении косяков.

Третий показатель — стоимость ошибки. Посчитайте, во сколько обходится каждая галлюцинация. Производитель мебели потерял заказ на 890 тысяч из-за неверной информации о сроках доставки. Бот соврал — клиент ушел к конкурентам.

Постоянное улучшение

Все шло нормально первые две недели. Потом началось — искажения стали появляться в неожиданных местах, система требовала еженедельных корректировок.

Оптимизация — это не разовая настройка. Это постоянный процесс. Обновляйте базу знаний минимум раз в неделю, добавляйте новые кейсы из реальных диалогов.

Интернет-магазин электроники внедрил практику еженедельных аудитов. Аналитик проверял 50 случайных диалогов каждый понедельник. Результат? Количество ошибок искусственного интеллекта снизилось с 31% до 8% за два месяца. Клиент был приятно удивлен скоростью улучшений.

Но не все прошло гладко. Потребовалась доработка промптов для трети сценариев — оригинальные формулировки давали сбои при нестандартных вопросах. Бюджет на доработку оказался выше — 180 тысяч вместо планируемых 70 тысяч.

Четыре шага для постоянной оптимизации:

- Собирайте обратную связь от операторов ежедневно

- Анализируйте проблемные диалоги каждую пятницу

- Обновляйте инструкции для нейросети раз в неделю

- Тестируйте изменения на контрольной группе перед внедрением

⚠️ Частая ошибка

Компании настраивают систему один раз и забывают про неё. Через месяц галлюцинации возвращаются, потому что ассортимент обновился, а база знаний нет.

Масштабирование требует автоматизации проверок. Банк с 2,4 млн клиентов внедрил автоматический фактчекинг — система сверяет ответы бота с актуальной базой данных в реальном времени. Стоимость разработки составила 520 тысяч рублей, окупилось за четыре месяца.

И последнее. Создайте цикл обратной связи: клиенты → операторы → аналитики → разработчики → обновление системы. Звучит сложно, но это единственный способ держать качество на высоте. Цикл должен работать непрерывно, как конвейер.

Выводы и рекомендации

Ключевые выводы

Галлюцинации нейросетей — это реальная угроза для бизнеса. Но не смертельная. Если честно, большинство проблем возникают не из-за самой технологии, а из-за неправильного подхода к внедрению.

Вот что действительно важно. Первое — никогда не доверяйте AI слепо. Второе — проверка фактов должна стать обязательным этапом работы. И третье — обучайте команду распознавать признаки галлюцинаций до того, как они попадут к клиентам.

Мы видели десятки компаний, которые потеряли клиентов из-за ошибок искусственного интеллекта. Интернет-магазин с оборотом 12 млн рублей потерял 340 тысяч за месяц из-за того, что бот выдавал несуществующие характеристики товаров. А один банк чуть не получил штраф от регулятора за недостоверную информацию о кредитных продуктах.

⚠️ Частая ловушка Думать, что дорогая модель не галлюцинирует. Даже GPT-4 выдает ложную информацию в 3-7% случаев по нашим наблюдениям.

Но есть и хорошие новости. Правильно настроенная система проверок снижает риски галлюцинаций нейросетей до минимума. Речь о комбинации: human-in-the-loop для критичных операций, автоматическая верификация через внешние источники, регулярный аудит ответов. Да, это требует времени. Зато работает.

План действий

Начните с аудита текущих процессов. Где именно вы используете AI? Какие данные он обрабатывает? Насколько критичны ошибки в этих точках? Запишите все сценарии использования — от генерации контента до обработки обращений клиентов.

Дальше внедряйте систему проверок поэтапно. Не пытайтесь автоматизировать все сразу. Начните с одного процесса, отработайте механизм валидации, потом масштабируйте на остальные направления.

Первый месяц будет сложным. Наш клиент из e-commerce потратил 47 часов только на настройку правил проверки для карточек товаров. Пришлось переделывать треть промптов, добавлять дополнительные источники данных, обучать команду работе с системой. Но через два месяца количество жалоб на неточности упало с 23 до 2 в неделю.

💡 Из опыта Закладывайте на внедрение системы проверок в 2-3 раза больше времени, чем планировали. Реальные сроки всегда оказываются больше.

Создайте чек-лист для команды. Простой документ на 1-2 страницы с четкими критериями: что проверять, как проверять, куда эскалировать проблемы. А главное — назначьте ответственного за мониторинг качества ответов AI. Это не должно быть "обязанностью всех", нужен конкретный человек.

И последнее — не экономьте на обучении. Ваша команда должна понимать, как работают подобные погрешности, почему они возникают, как их распознавать. Проводите короткие воркшопы раз в месяц, разбирайте реальные кейсы ошибок, обновляйте инструкции.

Хотите узнать, как чат-боты могут помочь именно вашему бизнесу? Оставьте заявку, и наши специалисты проведут бесплатный аудит процессов. Есть срочные вопросы? Пишите в Telegram или звоните 8(988)116-26-14. Мы поможем настроить систему так, чтобы AI работал на вас, а не создавал проблемы.

Нужна помощь с автоматизацией?

Оставьте заявку — наши специалисты проведут бесплатный аудит и предложат решение под ваши задачи.

Есть вопросы? Пишите в Telegram — отвечаем быстро и по делу. Первая консультация бесплатна, а результат превзойдет ожидания.

Часто задаваемые вопросы

ChatGPT генерирует правдоподобные ответы на основе паттернов из обучающих данных, но не проверяет их достоверность. Полностью устранить галлюцинации невозможно, но можно снизить их количество на 80-90% с помощью валидации данных, ограничения контекста и системы фактчекинга.

Готовы автоматизировать ваш бизнес?

Хотите узнать, как чат-боты могут помочь именно вашему бизнесу? Оставьте заявку, и наши специалисты проведут бесплатный аудит процессов.

Есть срочные вопросы? Пишите в Telegram. Свяжитесь с нами прямо сейчас — первая консультация бесплатна, а результат превзойдет ожидания.

Комментарии (0)

Читайте также

Похожие статьи, которые могут вас заинтересовать