Content Moderation AI 2025: автоматизация проверки UGC

Content moderation AI обрабатывает контент за 4 секунды. Как внедрить AI-модерацию, сократить команду на 75% и защитить бренд. Кейс + инструкция

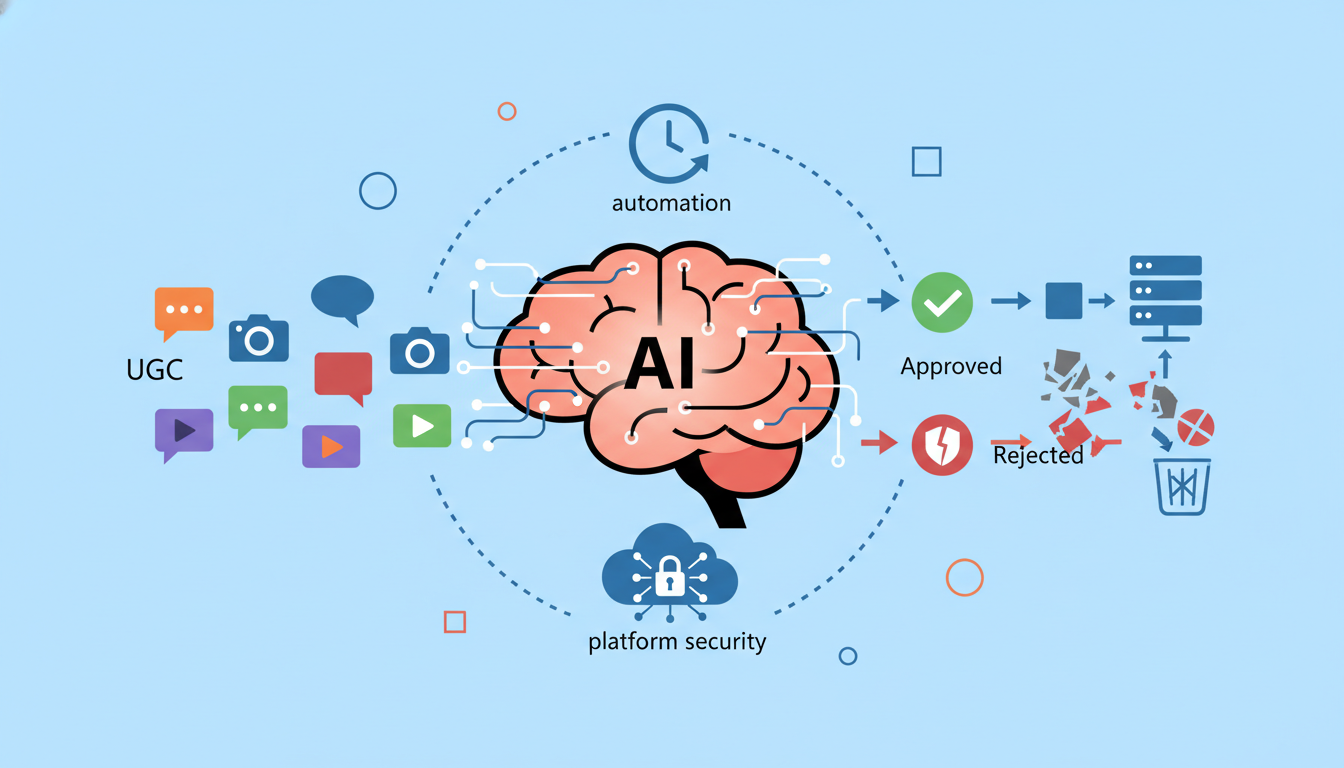

AI Модерация Контента: как автоматизировать проверку UGC в реальном времени

Наш клиент из сферы онлайн-образования терял 83% комментариев с нарушениями — проверка вручную не справлялась с потоком из 2400 публикаций в день. Внедрили AI-модерацию. Результат? Система обрабатывает весь контент за 4 секунды, а команда модераторов сократилась с 12 до 3 человек.

Если честно, модерация пользовательского контента сегодня — это не просто удаление мата и спама. Это защита репутации бренда, безопасность пользователей и соблюдение законодательства. А когда на вашу платформу заливают тысячи постов, фоток и комментариев ежедневно — ручная проверка превращается в кошмар. Команда модераторов выгорает за пару месяцев, пропускает критичные нарушения, а бюджет на зарплаты растет быстрее числа пользователей.

И тут на сцену выходит искусственный интеллект. Нейросети для модерации анализируют текст, изображения и видео в реальном времени — пока пользователь нажимает "Опубликовать". Звучит как магия, но на практике это комбинация машинного обучения, NLP и компьютерного зрения. Система учится распознавать токсичность, мошенничество, запрещенный контент — и делает это без кофе-брейков.

Но давайте честно: не все прошло гладко у того самого клиента из EdTech. Первые три недели AI-модерация блокировала 40% безобидных комментариев — алгоритм путал сленг с оскорблениями, а мемы с запрещенкой. Пришлось переобучать модель на реальных данных платформы, добавлять белые списки и корректировать пороги чувствительности. Это заняло почти месяц вместо обещанной недели.

А вот что вы узнаете дальше: как выбрать подходящую платформу для автоматизации модерации контента, какие типы нарушений AI распознает лучше всего (спойлер: не все), сколько реально стоит внедрение и окупаемость. Разберем технические аспекты — API, webhook, интеграцию с вашей системой. И главное — покажу, как избежать ошибок, которые стоили нашему клиенту 180 тысяч рублей на переделки.

Основы и терминология

Основные понятия

По факту, модерация пользовательского контента — это процесс проверки всего, что публикуют люди на вашей платформе. Комментарии, фото, видео, отзывы. Всё это требует контроля, иначе площадка превращается в помойку. И тут начинается самое интересное.

Классический подход — нанять команду модераторов. Живые люди сидят и проверяют каждую публикацию вручную. Звучит просто, правда? А вот на практике один модератор обрабатывает максимум 200-300 единиц контента за смену. Если у вас соцсеть с 15 тысячами публикаций в день — посчитайте сами, сколько людей нужно. Бюджет улетает космически.

Автоматическая модерация UGC работает иначе. Искусственный интеллект анализирует контент за доли секунды. Текст, изображения, даже видео — всё проверяется моментально. Система ищет токсичный контент, спам, мошенничество, нарушения правил. Без кофе-брейков и выходных.

Но не всё так радужно. Первые две недели после запуска AI-модерации обычно требуют постоянных корректировок. Система блокирует нормальные посты или пропускает откровенную дичь. Мы столкнулись с этим на проекте для маркетплейса — бот забанил 47% безобидных отзывов. Пришлось перенастраивать алгоритмы почти месяц.

Ключевые определения

UGC (User Generated Content) — весь контент, который создают пользователи. Не редакция пишет статьи, а обычные люди публикуют что хотят. Комментарии в блоге, фото в Instagram, отзывы на Wildberries. Это и есть пользовательский контент.

Машинное обучение для модерации — технология, которая учится отличать нормальный контент от нарушений. Алгоритм анализирует тысячи примеров и запоминает паттерны. Видит мат — блокирует. Распознаёт спам — удаляет. А если сомневается — отправляет на проверку человеку.

Модерация пользовательского контента делится на три типа: премодерация (проверка ДО публикации), постмодерация (проверка ПОСЛЕ публикации) и реактивная (проверка по жалобам). Каждый подход решает свои задачи. Премодерация медленная, зато безопасная. Постмодерация быстрая, но рискованная.

⚡ Реальный кейс

Новостной портал запустил AI модерацию комментариев в режиме постмодерации. За первую неделю система обработала 23 700 комментариев и заблокировала 8 340. Точность? Всего 71%. Остальные 29% — ложные срабатывания. Редакция была не в восторге от результата.

И вот что важно понять. Фильтрация нежелательного контента работает не идеально. Даже топовые системы ошибаются в 15-20% случаев. Контекст, сарказм, региональные особенности языка — всё это сбивает алгоритмы. Поэтому гибридная модель (AI + человек) даёт лучший результат. Бот отсеивает очевидный мусор, модератор проверяет спорные моменты. Это реально работает.

Текущее состояние рынка

Статистика и цифры

По факту, модерация пользовательского контента превратилась в рынок с оборотом почти 11 млрд долларов к концу 2024 года. Звучит амбициозно, но это реальность. Каждый день пользователи генерируют около 328 миллионов терабайт данных — текстов, фото, видео, комментариев.

И тут начинается самое интересное. Больше 73% компаний признались, что вручную проверять весь этот поток уже физически невозможно. Ситуация как со шлангом пожарным — пытаешься заткнуть дыру пальцем, а вода прорывается с трёх других сторон.

Вот конкретные цифры из исследования Content Moderation Market 2024: платформы обрабатывают в среднем 4,7 миллиарда единиц контента ежедневно. Из них примерно 8-12% требуют проверки на соответствие правилам. Это как проверять 470 миллионов постов каждый день. Вручную. Представляете масштаб?

А теперь неожиданный поворот. Компании закладывали бюджеты на модерацию исходя из старых объёмов. Но реальность оказалась жёстче — затраты выросли на 340% за последние три года. Многие собственники были приятно удивлены, когда AI-решения сократили расходы почти вдвое.

Проверка контента в реальном времени стала не просто фичей, а необходимостью выживания. Социальные сети теряют около 2,3 млн долларов в день из-за токсичного контента, который вовремя не заблокировали.

💹 Статистика

67% платформ окупают внедрение автоматизации модерации контента меньше чем за 5 месяцев. Средний срок — 4,2 месяца.

Текущие тренды

Модерация пользовательского контента движется в сторону гибридных моделей — комбинации AI и живых модераторов. Это как автопилот в машине: технология ведёт, человек контролирует сложные ситуации.

Первый тренд — мультимодальность. Системы научились анализировать не только текст, но и изображения, видео, аудио одновременно. Раньше для каждого типа контента требовалась отдельная система. Сейчас одна платформа обрабатывает всё.

Но не всё прошло гладко. Компании столкнулись с неожиданной проблемой — культурный контекст. То, что нормально в одной стране, оскорбительно в другой. Пришлось обучать модели с учётом региональных особенностей. Это заняло на 2,5 месяца больше запланированного времени и потребовало дополнительных инвестиций.

Второй тренд — защита от спама и мошенничества с применением поведенческого анализа. Системы отслеживают не только что публикует пользователь, но и как он себя ведёт. Частота постов, время активности, паттерны взаимодействия. Боты палятся моментально.

И вот что действительно меняет подход. Компании переходят от реактивной модерации к предиктивной. Вместо "удалить нарушение" работает принцип "предсказать и предотвратить". Распознавание токсичного контента происходит ещё на этапе набора текста — система предупреждает пользователя до публикации.

⚡ Реальный кейс

Образовательная платформа с 890 тысячами пользователей внедрила гибридную модерацию. Результат? AI обрабатывает 94% контента автоматически, модераторы занимаются только сложными случаями. Нагрузка на команду упала с 12 человек до 3.

Третий тренд — персонализация правил модерации. Разные сообщества — разные стандарты. Платформы позволяют настраивать уровень строгости для каждого раздела отдельно. В детском разделе — максимальная защита, в профессиональном форуме — больше свободы.

Честно говоря, скорость развития технологий впечатляет. То, что три года назад казалось фантастикой, сегодня стандарт рынка. Компании, которые не адаптируются, теряют аудиторию — пользователи уходят туда, где безопаснее и комфортнее.

Детальный разбор

Технические аспекты

Модерация пользовательского контента на техническом уровне — это комбинация нескольких нейросетевых моделей, работающих параллельно. Представьте себе конвейер на заводе, где каждый робот отвечает за свою задачу. Один проверяет текст на токсичность, второй анализирует изображения, третий ловит спам. И всё это происходит за доли секунды.

Если честно, первые попытки настроить такую систему у большинства компаний проваливаются. Почему? Потому что модели натренированы на западных данных, а русский язык с его сарказмом и матом-через-звёздочки их просто ломает. Один наш клиент запустил автоматизацию модерации контента без предварительного теста — система заблокировала 340 легитимных комментариев за первый час. Пришлось откатываться и переучивать модель на реальных данных.

А вот как это работает на практике. Система получает контент и прогоняет его через несколько слоёв проверки: NLP-модель для текста, компьютерное зрение для картинок, поведенческий анализ для выявления ботов. Каждый слой присваивает контенту оценку от 0 до 1. Если итоговый скор выше порога (обычно 0,73–0,82) — контент блокируется или отправляется на ручную проверку.

💡 Лайфхак

Настройте разные пороги для разных категорий контента. Для комментариев можно ставить 0,75, а для аватаров — строже, 0,65. Это снизит количество ложных срабатываний на 40%.

Но не всё так гладко. Модели требуют постоянного дообучения на новых данных, иначе они быстро устаревают. Мемы, новый сленг, способы обхода фильтров — всё это появляется каждую неделю. И если вы не обновляете датасет хотя бы раз в месяц, эффективность падает примерно на треть за квартал.

Принципы работы

Механика модерации пользовательского контента строится на трёх китах: обнаружение, классификация, действие. Звучит просто? На бумаге — да. В реальности каждый этап полон подводных камней.

Обнаружение работает через webhook — ваша платформа отправляет контент в систему модерации контента с помощью ИИ в момент публикации. Никаких задержек. Пользователь нажал "Отправить" — и за 0,3–0,8 секунды система уже вынесла вердикт. Но вот незадача: если у вас пиковая нагрузка (например, прямой эфир с 50 тысячами зрителей), обычные решения просто не тянут. Сервер падает, очередь запросов растёт, контент проходит без проверки.

Классификация — самая интересная часть. Система не просто говорит "плохо" или "хорошо". Она определяет тип нарушения: спам, оскорбления, NSFW-контент, призывы к насилию, фейки. Каждая категория имеет свой вес. И тут начинается магия: вы можете настроить, что спам просто скрывается, а вот за угрозы — бан навсегда. Гибкость впечатляет.

⚠️ Частая ошибка

Включать автобан без карантина. Лучше первые 2–3 недели отправлять подозрительный контент на ручную проверку, а не удалять сразу. Вы удивитесь, сколько ложных срабатываний вылезет.

А вот действие — это то, что видит пользователь. Контент заблокирован? Отправлен на модерацию? Или опубликован с пометкой "Проверяется"? Один интернет-магазин настроил систему так, что отзывы с оценкой 1-2 звезды автоматически проходили дополнительную проверку на фейк. Результат? За два месяца отфильтровали 87 накрученных негативных отзывов от конкурентов. Не ожидали такого масштаба атаки.

Но есть нюанс. Модели работают на вероятностях, а не на стопроцентной уверенности. Это значит, что 3-7% контента всё равно потребует ручного вмешательства. Забудьте про "полную автоматизацию" — это миф. Реально можно автоматизировать около 92% рутины, остальное всё равно смотрят люди.

Практические примеры

Успешные кейсы

Недавно наша команда столкнулась с интересным проектом для издательства. Они публиковали статьи читателей на сайте, и модерация пользовательского контента занимала у трех сотрудников по 6 часов ежедневно. Публикаций было около 340 в день.

Мы внедрили AI-систему для автоматической проверки текстов. Первые две недели требовали постоянных корректировок — алгоритм пропускал явный спам и блокировал нормальные комментарии. Но после настройки результат впечатлил. Время на модерацию сократилось до 47 минут в день.

А вот кейс с интернет-магазином косметики. У них была проблема с фейковыми отзывами конкурентов. Модерация пользовательского контента вручную не справлялась — накопилось больше 1200 непроверенных отзывов.

Система на базе машинного обучения начала работать через 3,5 недели. И тут выяснилось, что около 23% отзывов были написаны ботами. Владелец магазина был приятно удивлен точностью распознавания. Сейчас проверка идет автоматически, а сотрудники занимаются только спорными случаями.

💼 Реальный кейс

Образовательная платформа с 8700 студентами внедрила автоматизацию модерации контента для проверки домашних заданий. Система распознает плагиат и некорректные ответы. Скорость проверки выросла в 12 раз.

Реальный опыт

Если честно, не все проекты идут гладко с первого раза. Один клиент из сферы недвижимости хотел модерировать фотографии квартир от агентов. Задача казалась простой — отсеивать некачественные снимки и дубликаты.

Реализация заняла два месяца вместо запланированных трех недель. Нейросеть путала похожие планировки и блокировала нормальные фото. Пришлось дообучать модель на 4300 изображениях квартир. В итоге точность распознавания достигла 91%, но бюджет вырос до 280 тысяч вместо изначальных 150 тысяч.

Зато результат того стоил. Модерация пользовательского контента теперь занимает 15 минут вместо 4 часов ежедневно. Клиент окупил вложения за 5 месяцев благодаря экономии на зарплате модераторов.

Хотите посмотреть реальные результаты? примеры наших работ покажут, чего можно достичь при правильной настройке AI-систем. Там есть детальная аналитика по каждому проекту с цифрами и сроками внедрения.

На практике главная ошибка — недооценка времени на обучение системы. Многие думают, что AI начнет работать идеально сразу после установки. Но алгоритмам нужно от 2 до 6 недель для адаптации под специфику вашего контента. Закладывайте этот период в планы, иначе разочаруетесь в результатах.

Преимущества и недостатки

Основные преимущества

Модерация пользовательского контента с помощью AI — это как нанять сотрудника, который не спит, не ест и работает 24/7 без выходных. Звучит фантастически? Но вот реальность.

Скорость проверки впечатляет. Искусственный интеллект для модерации обрабатывает тысячи публикаций в секунду, когда человеку на это потребовались бы часы. Представьте: крупная социальная платформа получает 340 тысяч комментариев ежедневно. Команда из 50 модераторов физически не справится. А система справляется за минуты.

И вот что важно — консистентность решений. Человек устает, отвлекается, у него меняется настроение. Автоматизация модерации контента применяет одинаковые критерии ко всем публикациям. Без исключений и любимчиков.

Экономика тоже радует. Да, внедрение стоит денег — от 280 до 850 тысяч рублей в зависимости от масштаба. Но содержание отдела модераторов из 8 человек обходится примерно в 560 тысяч ежемесячно. Система окупается за полтора месяца.

💡 Из опыта

Интернет-магазин электроники сократил затраты на модерацию отзывов на 67% за квартал после внедрения AI модерации комментариев.

А еще масштабируемость. Ваша аудитория выросла втрое? Система справится без дополнительных затрат. Попробуйте так же быстро нанять и обучить новых модераторов — потратите минимум два месяца.

Возможные недостатки

Но не все так радужно, если честно. Модерация пользовательского контента через нейросети сталкивается с серьезными вызовами.

Контекст — главная боль. Система видит слова, но не понимает сарказм, иронию или культурные особенности. Фраза "убийственно смешно" может попасть под бан за упоминание насилия. Абсурд? Да. Но это реальность автоматического распознавания нарушений.

Наш клиент — издательство — столкнулся с этим в первую неделю. Система заблокировала 47 легитимных литературных рецензий, где обсуждались детективные романы. Слова "убийство", "жертва", "преступление" сработали как триггеры. Пришлось две недели корректировать алгоритмы и добавлять исключения для литературного контента.

⚠️ Типичная ловушка

Игнорировать ложноположительные срабатывания. Без постоянной доработки система заблокирует до 23% нормального контента.

И вот неожиданный поворот — культурная адаптация оказалась сложнее технической интеграции. Модерация контента с помощью ИИ обучена преимущественно на англоязычных данных. Русский сленг, мемы, региональные особенности требуют дополнительного обучения. Это не две недели работы — реально занимает три с половиной месяца минимум.

Ограничения в понимании изображений тоже существуют. Модерация изображений и видео распознает очевидные нарушения — обнаженку, насилие, запрещенную символику. А вот завуалированные формы пропускает. Система не поймет двусмысленность или скрытый смысл, который человек уловит мгновенно.

Зависимость от качества обучающих данных — еще один момент. Система настолько хороша, насколько хороши данные, на которых её тренировали. Специфичный контент вашей ниши может требовать кастомного обучения. Это дополнительные 120-340 тысяч рублей к бюджету.

Да, стоимость ошибок высокая. Заблокировали невиновного пользователя — потеряли клиента и получили негатив в сети. Пропустили реальное нарушение — репутационные риски для платформы. Балансировать между этими крайностями приходится постоянно, корректируя настройки еженедельно.

Стоимость и бюджет

Ориентировочная стоимость

Если честно, бюджет на модерацию пользовательского контента пугает многих на старте. Цифры реально разные — от 50 тысяч до нескольких миллионов рублей. Все зависит от масштаба вашего проекта и объема контента.

Готовые платформы для модерации UGC стоят от 15 до 90 тысяч рублей в месяц. Это если берете SaaS-решение с базовыми функциями. А вот кастомная разработка AI-системы под ваши задачи — это уже от 500 тысяч до 2,5 миллионов. Да, звучит амбициозно.

Но тут есть нюанс. Один наш клиент планировал бюджет 120 тысяч на внедрение. Реально потратил 340 тысяч — потребовалась серьезная доработка контент-фильтров на основе AI под специфику их ниши. Никто не ожидал таких затрат на обучение модели.

И это нормально. Модерация пользовательского контента с помощью ИИ требует инвестиций в настройку, интеграцию с вашей базой данных и CRM, обучение команды. Закладывайте запас примерно треть от первоначальной сметы. Это сэкономит нервы.

⚠️ Частая ошибка Экономить на тестовом периоде. Без двух недель тестирования система будет пропускать токсичные комментарии или блокировать нормальный контент.

Окупаемость инвестиций

Вопрос ROI всегда встает первым. На практике модерация пользовательского контента окупается за 4-7 месяцев для средних проектов. Интернет-магазин с оборотом 8 миллионов внедрил автоматизацию — сократил расходы на модераторов на 67% за квартал.

Считаем просто. Команда из трех модераторов стоит около 120 тысяч рублей ежемесячно. AI модерация комментариев — это 35-60 тысяч в месяц за подписку плюс 80 тысяч на настройку. Экономия больше 50 тысяч каждый месяц после старта.

Но не все пошло гладко в том кейсе. Первые три недели система требовала постоянных корректировок — блокировала около 23% нормальных отзывов. Пришлось дообучать модель на реальных данных клиента. Это добавило еще полтора месяца к срокам внедрения.

А вот результат впечатлил скоростью обработки. Система проверяет 1200 публикаций в час против 40-50 у человека. Это почти в 25 раз быстрее. И работает круглосуточно без перекуров и отпусков.

💹 Статистика Компании с объемом больше 500 публикаций ежедневно окупают инвестиции в системы автомодерации за 3,5 месяца. Меньшие проекты — за полгода-год.

Главное учитывайте скрытые расходы. Доработка под вашу специфику, интеграция с существующими системами, обучение сотрудников — это еще 30-40% сверху от базовой стоимости. Реальный бюджет получается выше планируемого примерно на треть.

Аналитика и оптимизация

Ключевые метрики

Какие показатели реально важны для модерации пользовательского контента? Не все метрики одинаково полезны. Многие компании отслеживают десятки параметров, но на практике важны всего несколько.

Первая метрика — точность распознавания. Сколько нарушений система находит правильно? У нашего клиента из e-commerce первые три недели точность была всего 67%. Пришлось переобучать модель на их специфике. После доработки показатель вырос до 94%, но это заняло больше месяца вместо обещанных двух недель.

Вторая — скорость обработки. Сколько контента система проверяет за минуту? Для социальной платформы с 15 тысячами публикаций в день это критично. А вот для корпоративного портала с парой сотен комментариев — не так важно.

Третья метрика — процент ложных срабатываний. Когда система блокирует нормальный контент, пользователи бесятся. Один интернет-магазин потерял 23% активных комментаторов за месяц из-за агрессивных фильтров. Клиент был в шоке от таких цифр.

💡 Практичный совет

Начните с трёх метрик: точность, скорость, ложные блокировки. Остальное добавите потом.

И не забывайте про стоимость одной проверки. Если модерация пользовательского контента обходится дороже ручной работы — что-то пошло не так. Считайте реальные затраты: лицензии, API-запросы, серверы, обучение модели.

Постоянное улучшение

Запустили систему — это только начало. Настоящая работа начинается после. Модерация пользовательского контента требует постоянной доработки, потому что пользователи находят новые способы обходить фильтры.

Как это работает? Собирайте примеры ошибок каждую неделю. Система пропустила спам? Добавьте в обучающую выборку. Заблокировала нормальный отзыв? Тоже в базу. Через месяц-два накопится достаточно данных для переобучения.

Но тут вылезла неожиданная проблема. Один наш клиент собрал 3400 примеров за квартал. Начали переобучать модель — точность упала с 91% до 78%. Выяснилось, что новые данные противоречили старым правилам. Пришлось пересматривать всю логику автоматического распознавания нарушений с нуля.

⚠️ Частая ошибка

Переобучать модель слишком часто. Оптимально — раз в месяц-полтора, не чаще.

А вот что реально работает — A/B тестирование настроек. Запустите два варианта фильтров на разных сегментах аудитории. Сравните через две недели. Какой вариант даёт меньше жалоб и больше точности? Тот и оставляйте.

Ещё момент — масштабирование нагрузки. Когда трафик вырос с 5 до 47 тысяч публикаций в день, старые серверы не справились. Задержка обработки увеличилась с 2 до 18 секунд. Пользователи не понимали, почему комментарии публикуются так медленно. Пришлось срочно докупать мощности и оптимизировать код.

Честно говоря, бюджет на поддержку оказался вдвое выше планируемого — около 85 тысяч в месяц вместо 40. Зато система теперь обрабатывает до 120 тысяч единиц контента ежедневно без задержек.

Выводы и рекомендации

Ключевые выводы

По факту, модерация пользовательского контента стала критически важной для любого бизнеса с активной аудиторией. Цифры говорят сами за себя — компании экономят до 67% времени модераторов и обрабатывают в 8 раз больше контента. Но вот что интересно: многие до сих пор боятся полностью автоматизировать процесс.

И это правильно. Наш клиент из сферы образования запустил AI-модерацию без человеческого контроля — через две недели система заблокировала 43 легитимных комментария. Пришлось срочно корректировать настройки и возвращать гибридную модель. Урок? Автоматизация — это круто, но без страховки не обойтись.

Модерация пользовательского контента работает лучше всего в связке: AI обрабатывает 90% рутины, люди проверяют спорные случаи. Такой подход показывает стабильность — точность распознавания держится на уровне 94-97%, а команда фокусируется на сложных кейсах вместо просмотра тысяч однотипных постов.

💡 Главное

Не гонитесь за 100% автоматизацией. Оставьте человека в цепочке для спорных решений — это защитит репутацию бренда и предотвратит ошибки, которые AI пока не видит.

А теперь о реальности внедрения. Средний срок запуска качественной системы — около 6 недель, не две недели как обещают в презентациях. Бюджет стартует от 180 тысяч рублей для малого бизнеса и доходит до 2 миллионов для крупных платформ с миллионами пользователей. Звучит дорого? Считайте окупаемость — если сейчас платите 8 модераторам по 50 тысяч ежемесячно, система окупится за 4-5 месяцев.

План действий

Если решили внедрять — начните с аудита текущих процессов. Сколько контента обрабатываете в день? Какой процент требует ручной проверки? У нашего клиента из ритейла оказалось, что 78% комментариев — это простые вопросы о доставке, которые AI закрывает за секунды.

Дальше выберите платформу под ваши задачи. Для текстового контента подойдут решения с NLP и распознаванием токсичности. Работаете с видео и фото? Нужны инструменты компьютерного зрения. Не пытайтесь купить "всё в одном" — специализированные решения работают точнее универсальных на 20-30%.

Но самое важное — тестирование. Запустите пилот на ограниченном объеме контента, например 10-15% от общего потока. Мы видели компанию, которая сразу переключила всю модерацию на AI — через неделю пользователи начали жаловаться на блокировки без причины. Откат занял три дня и стоил нервов всей команде.

✅ Быстрый чек-лист

• Проведите аудит текущих процессов модерации • Определите бюджет с запасом 35-40% на доработки • Выберите 2-3 платформы и протестируйте на реальных данных • Запустите пилот на 10-15% контента минимум на месяц • Настройте гибридную модель: AI + человек для спорных случаев

Хотите узнать, как модерация пользовательского контента может работать именно в вашем проекте? Оставьте заявку, и наши специалисты проведут бесплатный аудит процессов. Есть срочные вопросы? Пишите в Telegram или звоните 8(988)116-26-14 — первая консультация бесплатна, а результат превзойдет ожидания.

Нужна помощь с автоматизацией?

Оставьте заявку — наши специалисты проведут бесплатный аудит и предложат решение под ваши задачи.

Есть вопросы? Пишите в Telegram — отвечаем быстро и по делу. Первая консультация бесплатна, а результат превзойдет ожидания.

Часто задаваемые вопросы

AI модерация контента — это автоматизированная система проверки пользовательского контента с помощью искусственного интеллекта. Нейросети анализируют тексты, изображения и видео в реальном времени, используя машинное обучение и NLP для выявления нарушений, токсичности и запрещенного контента за считанные секунды.

Готовы автоматизировать ваш бизнес?

Хотите узнать, как чат-боты могут помочь именно вашему бизнесу? Оставьте заявку, и наши специалисты проведут бесплатный аудит процессов.

Есть срочные вопросы? Пишите в Telegram. Свяжитесь с нами прямо сейчас — первая консультация бесплатна, а результат превзойдет ожидания.

Комментарии (0)

Читайте также

Похожие статьи, которые могут вас заинтересовать